Déploiement de OPNFV Colorado 3.0 avec VOSYSwitch

Introduction à OPNFV et son intégration avec un switch virtuel à haute performance

OPNFV (Open Platform for NFV Project) est un projet ouvert qui a pour objectif d'être une plate-forme intégrée qui puisse permettre d'introduire de nouveaux produits et services aux industriels. Autour des leaders de l'industrie de télécommunications, OPNFV a pour but d'améliorer le potentiel de NFV (Networking Functions Virtualization) et ainsi de fournir homogénéité et interopérabilité. La plate-forme met en place un écosystème pour les solutions de NFV basées sur des standards et des logiciels ouverts.

Dans ce contexte, un composant clés qui assure une simplicité de déploiement et des hautes performances est le commutateur virtuel. Pour cette raison, Virtual Open Systems a voulu élaborer ce guide qui traite de l'intégration de son commutateur virtuel {% atag lang 'vosyswitch-odp-armv8' 'multi architectures (x86 et ARMv8) VOSYSwitch avec OPNFV.

1. Intégration de VOSYSwitch comme plan de commutation dans OPNFV

Ce guide montre l'installation du commutateur VOSYSwitch au sein de OPNFV. VOSYSwitch est un switch virtuel haute performance fonctionnant en "espace utilisateur" qui est utilisé, dans le cas présent, comme plan de commutation de niveau 2 dans le réseau d'OpenStack Neutron.

Les informations d'installation de OPNFV disponible en ligne décrivent la procédure d'installation, soit pour un ensemble de machines virtuelles, soit pour un ensemble machines physiques. Au contraire, ce guide propose une solution qui utilise un environnemt mixte, qui inclut à la fois des machines virtuelles et physiques. Le scénario décrit ici, utilise les machines virtuels pour faire fonctionner les systèmes de management alors que les fonctions de calculs sont déployées sur les machines physiques. Cela correspond à une approche plus flexible pour déployer OPNFV, l'utilisateur peut ainsi dédier des ressources physiques à des tâches spécifiques, alors que les machines demandant moins de ressources sont virtualisées.

A la fin de guide, nous présentons les résultats d'un test de performance entre une installation d'OPNFV fonctionnant avec VOSYSwitch et une fonctionnant avec OVS-DPDK, l'environnemt de test étant le même dans les deux cas.

Ici, il est présenté un extrait du tableau de performance complet, qui est montré à la fin de ce guide. Il est clairement démontré comment la solution VOSYSwitch surpasse OVS-DPDK, pour fournir une connectivité supérieure pour les VM. Une intégration simple de VOSYSwitch dans OPNFV fournit aux opérateurs, aux fournisseurs de services et aux intégrateurs une solution exceptionnelle pour permettre des déploiements de production de classe opérateur. En outre, le déploiement facile de VOSYSwitch dans des centres de données hétérogènes de cloud computing et de télécommunication, combinant les architectures de serveurs x86 et ARMv8, résout enfin les limites d'interopérabilité d'autres solutions de marché vSwitch disponibles actuellement. VOSYSwitch a été prouvé pour soutenir des performances plus élevées lors de l'utilisation d'un réseau isolé multi-locataire VLAN; Il surperforme dans les deux scénarios de inter-hôte et même hôte, lors de l'utilisation iperf avec un modèle TCP réaliste.

Scenario Parallel threads MTU size OVS-DPDK VOSYSwitch même hôte 1 1500 2.14 Gbps 10.3 Gbps inter-hôte 1 1500 4.88 Gbps 9.20 Gbps

2. Configuration de l'infrastructure OPNFV

Ce guide est basé sur la dernière version disponible de la distribution OPNFV Colorado 3.0, l'infrastructure est crée en suivant les recommandations de OPNFV Pharos hardware specifications.

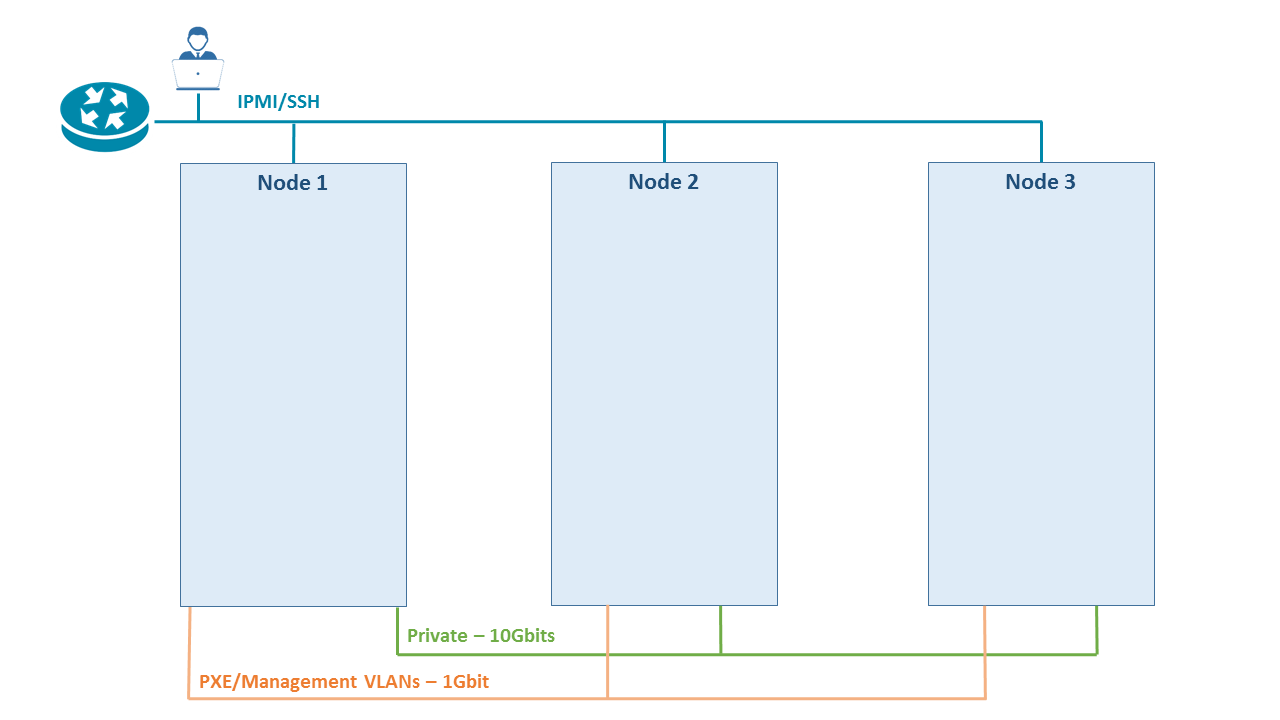

L'agencement physique de l'installation est décrite en Figure 1.

Figure 1 - Vue d'ensemble

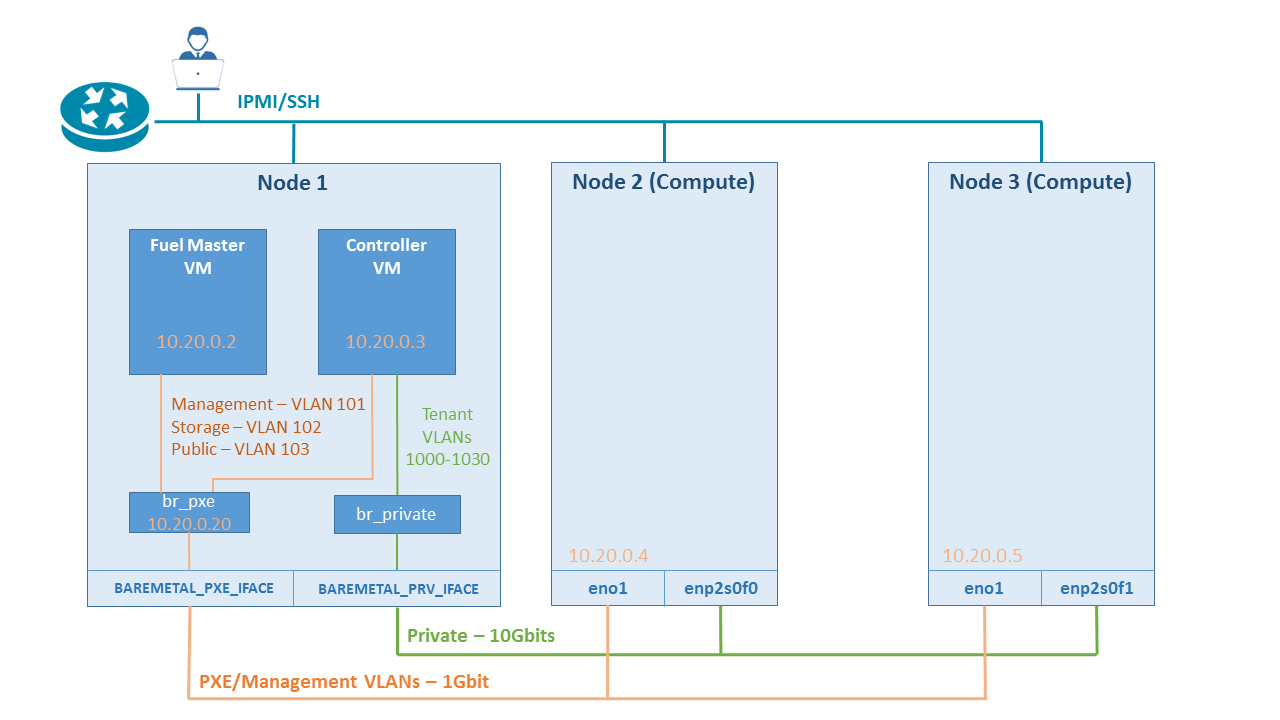

Une machine (Noeud 1) avec Ubuntu 16.04 sert d'hôte pour les machines virtuelles "Fuel Master" et "Openstack Controller". Elle a les spécifications suivantes:

- Supermicro Super Server

- 8 x 8GB RAM Memory

- Intel(R) Xeon(R) CPU E5-2687W v3 @ 3.10GHz

- 2 x Intel Corporation I350 1Gb

- Intel Corporation X710 10GbE SFP+

- 1TB Stockage

Les deux autres machines (Noeuds 2 et 3) servent de noeuds de calcul Openstack. Chacune d'elle à les spécifications suivantes:

- Supermicro Super Server

- 8 x 8GB RAM Memory

- 2 x Intel(R) Xeon(R) CPU E5-2630 v3 @ 2.40GHz

- Interface de management utilisant IPMI

- 2 x Intel Corporation I210 1Gb

- Intel Corporation X520 (82599ES based) 10GbE SFP+

- 1TB Stockage

Le réseau est constitué d'un ensemble de trois réseaux physiques:

- Réseau de management utilisant IPMI

- Réseau 1Gbit/s pour le management et le démarrage PXE

- Réseau 10Gbits/s servant de réseau Privé

La structure fonctionnelle du réseau OpenStack déployé est montrée en Figure 2.

Figure 2 - Vue d'ensemble logique

Les logiciels et binaires nécessaires pour mener à terme ce guide sont fournis dans cet archive. Elle doit être extraite sur le Noeud 1 qui sert d'hôte pour les machines virtuelles "Fuel Master" et "OpenStack Controller" (Figure 2).

3. Initialisation de l'environnement OPNFV

Attention!

Virtual Open Systems ne peut être tenu responsable pour tout dommage qui pourrait être causé, en suivant les instructions ci-dessous. Bien que le contenu de ce guide à été testé minutieusement, Virtual Open Systems ne peut garantir qu'aucune erreur ne puisse endommager le système cible.

Le script network.sh va créer l'environnement réseau sur le Noeud 1. Il est supposé que le réseau physique est câblé comme dans la Figure 1.

Les variables suivantes dans network.sh doivent être modifiées pour correspondre aux interfaces utilisées. Dans notre cas:

BAREMETAL_PXE_IFACE=eno2

BAREMETAL_PRV_IFACE=ens4f0

Lancer le script:

# ./network.sh

Le script réinitialise toujours tous le réseau, donc si une ré-initialisation de l'environnement est nécessaire, le script peut être invoqué a tout moment pour restaurer la configuration.

Durant le déploiement, Fuel utilise le réseau public pour se connecter à des dépôts externes dans le but de vérifier la connectivité. Pour permettre cela, une règle iptables doit être ajoutée au trafic sortant sur la machine hôte (Noeud 1).

# echo 1 > /proc/sys/net/ipv4/ip_forward

# iptables -t nat -A POSTROUTING -s "172.16.16.1/24" -o "e+" -j MASQUERADE

Pour permettre à QEMU d'utiliser le "ping", les requêtes ICMP doivent être activée. Pour cela, il faut ajouter la ligne suivante dans le fichier /etc/sysctl.conf:

net.ipv4.ping_group_range = 0 2147483647

On applique les changements en invoquant:

# sysctl -p

Une fois le réseau configuré, les machines virtuelles peuvent être initialisées:

# ./init_vms.sh

Le résultat de ce script devrait être un ensemble d'images pour les machines virtuelles "Fuel Master" et "OpenStack Controler". Il est a noter que la dernière utilise 3 images disques.

Télécharger dans le même dossier l'installateur ISO Fuel depuis le site officiel d'OPNFV.

Identifiant ou inscription pour visualiser l'information complète

VOSySofficial

VOSySofficial